这项由加州大学伯克利分校的Akio Kodaira和Meta公司的Tingbo Hou、Ji Hou等研究人员共同完成的突破性研究,于2025年7月发表在计算机视觉顶级会议arXiv上。感兴趣的读者可以通过论文编号arXiv:2507.03745v1查阅完整研究内容。这项研究首次实现了真正意义上的实时视频生成,让人工智能可以像熟练的摄影师一样,根据你的文字描述即时生成高质量视频。

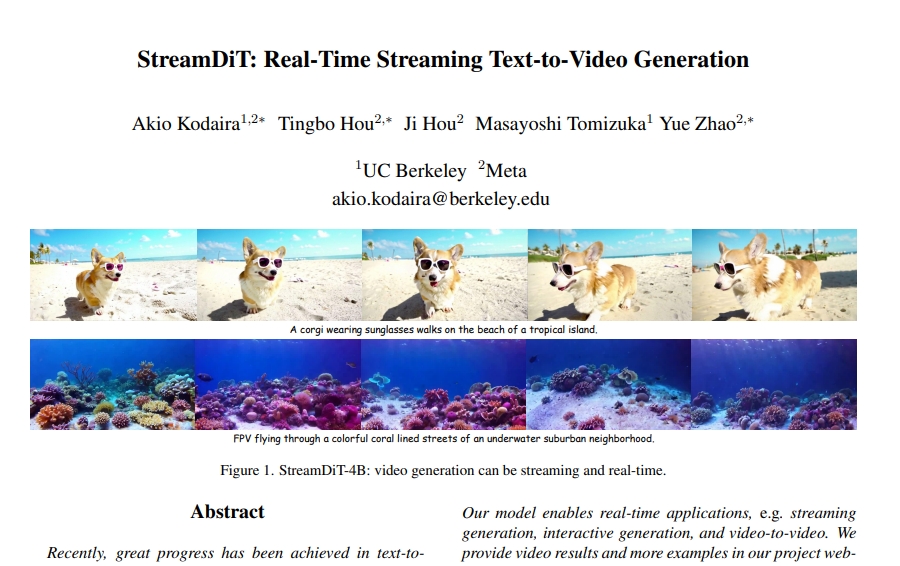

在传统的AI视频制作中,你需要输入文字描述,然后等待很长时间才能看到结果,就像在暗房里冲洗胶卷一样耗时。而这项新技术StreamDiT就像拥有了一个瞬间反应的智能摄影师,你说想要什么画面,它就能马上开始拍摄并实时播放给你看。更神奇的是,在视频播放过程中,你还可以随时改变想法,比如原本想拍一只在海滩上戴墨镜的柯基犬,看到一半时突然想换成在水下珊瑚街区飞行的画面,AI导演会立即调整拍摄方向,让画面自然过渡到新的场景中。

这种技术的革命性在于它打破了传统视频生成的时间壁垒。就像从写信通讯进化到即时聊天一样,StreamDiT让人与AI的视频创作变成了一场实时对话。研究团队训练了一个拥有40亿参数的AI模型,能够在一块GPU上以每秒16帧的速度生成512p分辨率的视频,真正做到了"所想即所见"的实时体验。这不仅仅是技术上的进步,更是创意表达方式的根本性变革。

一、突破传统视频制作的时间束缚

要理解StreamDiT的革命性意义,我们可以把传统的AI视频生成比作传统摄影。在胶片时代,摄影师拍摄一张照片后,需要回到暗房进行漫长的冲洗过程才能看到结果。类似地,现有的AI视频生成技术也需要用户输入文字描述,然后等待系统慢慢生成整个视频片段,这个过程可能需要几分钟甚至更长时间。

StreamDiT的出现就像数码相机的发明一样具有颠覆性。数码相机让摄影师能够立即看到拍摄结果,而StreamDiT则让AI视频生成变成了一个实时的创作过程。当你输入"一只戴着太阳镜的柯基在热带岛屿的海滩上行走"这样的描述时,系统不是先停下来思考几分钟再给你一个完整答案,而是立即开始"拍摄",让你实时看到视频画面的生成过程。

更重要的是,这种实时性还支持互动创作。在传统视频生成中,一旦开始制作就无法更改,就像已经按下快门的胶片相机无法重新构图一样。但StreamDiT允许你在视频生成过程中随时调整想法。比如你正在观看柯基在海滩漫步的画面,突然想要切换到"第一人称视角飞越彩色珊瑚围绕的水下郊区街道",你只需要输入新的描述,AI就会让画面自然过渡到新场景,就像一个经验丰富的摄影师能够流畅地切换镜头角度和场景一样。

这种技术的实现基础是研究团队设计的"流式缓冲区"机制。可以把这个机制想象成一条流水线,不同于传统方法需要等待整条生产线完成后才能看到产品,StreamDiT的流水线能够持续输出部分完成的产品。具体来说,系统维护着一个包含多帧画面的缓冲区,这些画面处于不同的完成阶段,有些还是模糊的草图,有些已经接近完成。随着处理的进行,最完成的画面会被输出给用户观看,同时新的草图画面会进入缓冲区开始处理。

二、让AI学会"边想边画"的创新训练方法

传统的AI视频生成训练就像教学生一次性完成整幅画作,而StreamDiT的训练更像是教艺术家学会在画布上同时处理多个处于不同完成阶段的作品。这种全新的训练方法被称为"缓冲流匹配",它是整个技术的核心创新。

在传统的训练中,AI需要学习如何从纯噪音(可以理解为完全混乱的像素点)逐步生成清晰的视频画面,这个过程就像从一张白纸开始绘制完整的画作。但StreamDiT的训练方法更加复杂和巧妙:它需要同时处理多个处于不同"绘制阶段"的画面。有些画面可能刚刚开始绘制,还是模糊的轮廓;有些画面已经有了基本形状和色彩;还有一些画面接近完成,只需要最后的细节修饰。

这种训练方法的关键在于"分块处理"策略。研究团队将视频帧分成不同的"块",每个块包含若干连续的帧,就像把一本连环画分成若干个章节。在训练过程中,AI需要学会同时处理这些不同章节的内容,确保它们在内容上保持连贯性。这就好比一个编剧需要同时构思故事的开头、中间和结尾,确保整个故事逻辑自洽、情节流畅。

为了让AI掌握这种复杂的处理能力,研究团队还设计了"混合训练"方案。这种方案就像让一个厨师同时学会制作不同复杂程度的菜品:有时候制作简单的单人餐,有时候准备复杂的宴席,有时候处理中等规模的家庭聚餐。通过这种多样化的训练,AI学会了在不同情况下都能保持稳定的表现。

具体而言,系统会在训练中随机选择不同的分块方案。有时候选择较小的块大小,这样处理速度更快但可能影响画面连贯性;有时候选择较大的块大小,这样画面质量更高但处理速度较慢。通过这种变化的训练,最终的AI模型获得了在不同应用场景下的适应能力,既能满足实时交互的速度要求,又能保证足够的视频质量。

三、打造高效的AI视频处理引擎

StreamDiT的模型架构就像一台精密设计的视频处理工厂,每个组件都经过优化以实现实时性能。整个系统基于Transformer架构构建,这是目前AI领域最先进的处理框架,就像现代汽车工厂采用最先进的自动化生产线一样。

模型的核心创新是"时变嵌入"设计。传统的视频AI模型就像一个只能按固定程序工作的机器人,每次处理时都使用相同的时间参数。而StreamDiT更像一个灵活的工匠,能够根据每帧画面的具体情况调整处理方式。对于那些刚开始处理的模糊画面,它会采用粗略快速的处理方法;对于接近完成的画面,它会进行精细的修饰工作。

为了提高处理效率,研究团队还采用了"窗口注意力"机制。可以把这个机制想象成一个摄影师的取景框:传统方法需要时刻关注整个巨大的场景,消耗大量精力;而窗口注意力让AI只专注于当前处理区域的局部细节,就像摄影师通过取景框专注于构图的特定部分。这种局部专注的方法大大降低了计算复杂度,使实时处理成为可能。

模型采用了40亿个参数的规模,这个数字听起来很大,但实际上是在性能和效率之间的精心平衡。可以把这些参数想象成一个经验丰富工匠掌握的各种技巧和知识:参数太少就像经验不足的新手,无法处理复杂情况;参数太多又像知识渊博但行动缓慢的老学者,无法满足实时应用的速度要求。40亿参数恰好让AI既有足够的"经验"生成高质量视频,又能保持足够的"敏捷"实现实时响应。

在视频编码方面,系统使用了专门的时空自编码器,压缩比率在时间维度上为4倍,在空间维度上为8倍。这就像一个高效的压缩专家,能够将原本庞大的视频数据压缩成便于处理的格式,而不丢失重要的视觉信息。这种压缩让系统能够在有限的计算资源下处理更多的视频内容。

四、从实验室到现实应用的完美蜕变

为了实现真正的实时应用,研究团队还开发了专门的"多步蒸馏"技术。这个过程就像把一位大师级厨师的复杂烹饪技艺教给快手厨师一样。原始的AI模型虽然能生成高质量视频,但需要128个处理步骤,就像大厨需要经过繁复的工序才能做出精美菜品。通过蒸馏技术,研究团队成功地将这个过程压缩到只需要8个步骤,就像教会快手厨师用简化的流程做出同样美味的菜品。

这种压缩并非简单的删减,而是智能的重组和优化。系统学会了哪些步骤是关键的,哪些可以合并或简化。最终的结果是,蒸馏后的模型在保持几乎相同视频质量的同时,处理速度提升了16倍,真正实现了在单个GPU上以每秒16帧的速度生成视频。

实验结果显示,StreamDiT在多个维度上都表现优异。在视频质量评测中,无论是主体一致性、背景连贯性、还是运动流畅性,StreamDiT都超越了现有的流式视频生成方法。更重要的是,在动态程度这个关键指标上,StreamDiT的表现远超其他方法,生成的视频具有更丰富的运动和变化,而不是静态重复的画面。

人工评估的结果更加令人印象深刻。在与其他先进方法的对比中,StreamDiT在整体质量、帧间一致性、运动完整性和运动自然度等四个关键维度上都获得了更高的用户评分。这意味着普通用户在实际使用中能够明显感受到StreamDiT生成视频的优越性。

五、开启视频创作的无限可能

StreamDiT的应用潜力远远超出了传统视频生成的范畴。首先是实时流媒体生成,这让AI能够像直播摄影师一样工作。用户可以实时调整视频内容,系统立即响应生成相应画面,整个过程就像在玩一个高度沉浸式的视频游戏。研究团队演示了长达5分钟的连续视频生成,证明了系统的稳定性和持续性。

交互式视频创作是另一个激动人心的应用方向。用户可以通过一系列相关的文字提示来引导故事发展,就像与AI合作编写和拍摄一部电影。例如,从"宁静的湖泊和白天多云的天空"开始,然后转向"夜晚月光下的安静湖泊和渐暗的微光",最后发展为"湖上绽放的烟花"。整个过程中,AI会保持场景的连贯性,同时根据新的提示调整内容。

视频到视频的转换功能展现了另一种创新应用模式。用户可以上传现有视频,然后通过文字描述对其进行实时修改。比如将一段小猪在街上行走的视频转换为小猫在相同场景中行走,背景和动作保持一致,只改变主要对象。这种功能对于视频编辑和内容创作具有巨大价值。

游戏和虚拟现实领域是StreamDiT最具前景的应用方向之一。传统游戏中的场景都是预先设计和渲染的,而StreamDiT使得根据玩家行为和选择实时生成游戏画面成为可能。这可能会彻底改变游戏设计理念,从预设内容转向动态生成内容。

教育和培训领域也能从这项技术中受益匪浅。教师可以根据教学需要实时生成相关的视觉内容,学生的理解程度和兴趣点可以立即反映在生成的视频中。这种互动性将大大增强学习体验的个性化程度。

六、技术挑战与未来发展方向

尽管StreamDiT取得了突破性进展,但研究团队也坦诚地指出了当前技术的局限性。最主要的挑战是长期记忆问题。当前的系统就像一个只有短期记忆的摄影师,只能记住最近拍摄的几个镜头,对于更早的内容会逐渐遗忘。这可能导致在长视频中出现人物面部不一致或背景细节丢失的问题。

另一个技术挑战是视频块之间的衔接问题。虽然在潜在空间中(也就是AI的"思维空间"中)视频帧之间连接流畅,但在转换为最终视频时,不同块之间可能出现轻微的跳跃或闪烁。这就像一个熟练的画家在脑海中构思完美,但在转移到画布上时可能出现细微的不连贯。

模型规模也是一个需要平衡的因素。当前的40亿参数模型在实时性和质量之间找到了良好平衡,但与一些拥有300亿参数的大型模型相比,在视频质量的绝对水平上仍有差距。研究团队已经在更大规模的模型上验证了方法的有效性,未来随着计算能力的提升,有望实现更高质量的实时视频生成。

计算资源的可及性是另一个实际考量。虽然StreamDiT已经能在单个高端GPU上运行,但这样的硬件配置对普通用户来说仍然昂贵。随着硬件技术发展和算法进一步优化,预期这种技术将逐渐普及到更广泛的设备上。

研究团队提出了几个有前景的改进方向。首先是集成长期记忆机制,比如结合状态空间模型来维持对早期内容的记忆。其次是改进视频解码策略,通过重叠解码等技术减少块间的视觉不连贯。第三是探索更高效的模型架构,在保持质量的同时进一步降低计算需求。

七、重新定义人机创作的边界

StreamDiT的意义远远超出了技术本身,它代表了人工智能从"工具"向"合作伙伴"的重要转变。在传统的创作模式中,人类提出需求,AI执行任务,两者之间是单向的指令关系。而StreamDiT开启了一种全新的协作模式:人类和AI可以进行实时的创意对话,就像两个艺术家在合作创作一件作品。

这种转变对内容创作行业可能产生深远影响。电影制作人可以在剧本创作阶段就实时可视化场景,编剧的文字描述可以立即转化为视觉画面,这将大大提高创作效率和质量。广告和营销行业可以根据客户反馈实时调整创意内容,使创意展示和修改变成一个动态交互的过程。

教育领域的变革可能更加深刻。传统教学中,教师需要提前准备大量视觉材料,而StreamDiT使得根据学生实时反应和理解程度动态生成教学内容成为可能。每个学生的学习路径都可以通过个性化的视觉内容得到支持,这种个性化程度是传统教学方法难以达到的。

从技术发展的角度看,StreamDiT也为AI视频生成领域指出了新的发展方向。实时性不再是一个可选的优化目标,而成为了必需的基础能力。这将推动整个领域朝着更加注重用户体验和交互性的方向发展。

隐私和伦理考量也变得更加重要。实时视频生成能力的普及可能带来新的挑战,比如实时深度伪造等问题。这需要技术开发者和政策制定者共同努力,在推动技术进步的同时建立相应的规范和防护机制。

说到底,StreamDiT最令人兴奋的地方不仅仅在于技术的先进性,更在于它为人类创造力的表达开辟了全新的可能性。就像印刷术让文字传播变得便捷,摄影技术让瞬间记录成为可能,StreamDiT正在让我们进入一个"所想即所见"的视觉创作新时代。在这个时代里,创意的表达不再受制于技术复杂性和时间成本,每个人都可能成为自己想象世界的导演。

当然,这项技术目前还处于研究阶段,距离普通用户的日常使用还有一段距离。但正如研究团队在论文中展示的那样,技术的快速发展正在让这些可能性变成现实。对于那些对技术细节感兴趣的读者,完整的研究论文可以通过arXiv:2507.03745v1获取,其中包含了更详细的技术实现和实验数据。

这项由加州大学伯克利分校和Meta公司合作完成的研究,不仅在技术上实现了重要突破,更重要的是为我们描绘了一个充满创意可能性的未来。在那个未来里,人类的想象力将不再受到表达工具的限制,每一个奇思妙想都可能瞬间转化为生动的视觉现实。

Q&A

Q1:StreamDiT是什么?它和普通的AI视频生成有什么区别? A:StreamDiT是一种能够实时生成视频的AI技术,最大区别就是"即时性"。传统AI视频生成需要等待几分钟才能看到结果,而StreamDiT可以像看直播一样实时生成和播放视频。更神奇的是,你还可以在视频播放过程中随时改变想法,AI会立即调整内容,就像有个超级灵活的摄影师在为你工作。

Q2:普通人现在能使用StreamDiT吗?需要什么设备? A:目前StreamDiT还处于研究阶段,普通用户暂时无法直接使用。它需要高端GPU设备才能运行(比如H100),这种设备对个人用户来说成本较高。不过随着技术发展和硬件普及,预计未来几年内可能会有更容易获取的版本出现。

Q3:StreamDiT生成的视频质量怎么样?会不会因为速度快而质量差? A:研究显示StreamDiT在保证实时性的同时还能维持高质量。它生成512p分辨率的视频,在用户评测中各项指标都超越了其他实时视频生成方法。虽然比起那些需要长时间计算的超高质量模型还有差距,但已经达到了实用级别,而且研究团队在更大的300亿参数模型上验证了方法的可扩展性。

诚多网提示:文章来自网络,不代表本站观点。